Slik forhindrer du at Google indekserer nettstedet ditt

Det kan være mange forskjellige grunner til å holde nettsteder utenfor Googles indeks. Det kan være et utviklingsmiljø eller du har problemer med duplikatinnhold på nettstedet ditt. Nedenfor er noen av de beste måtene å holde innholdet ditt skjult for Google.

Passordbeskytt servermappene dine

Generelt er det en god idé å holde innholdet ditt skjult og sikkert ved å bruke passordbeskyttede mapper hvis du ikke vil at uautoriserte personer skal kunne se det, eller at søkemotorer skal fange (gjennomsøke) det. Webcrawlere kan normalt ikke få tilgang til ting som er skjult bak en passordvegg. Hvis du er en utvikler, er det slik du bør prøve å jobbe og ikke lage et underdomene og legge utviklingen der. Det er ganske vanlig at utviklere glemmer å ekskludere Google. [mer_info_skjema]

Robots.TXT-direktiv

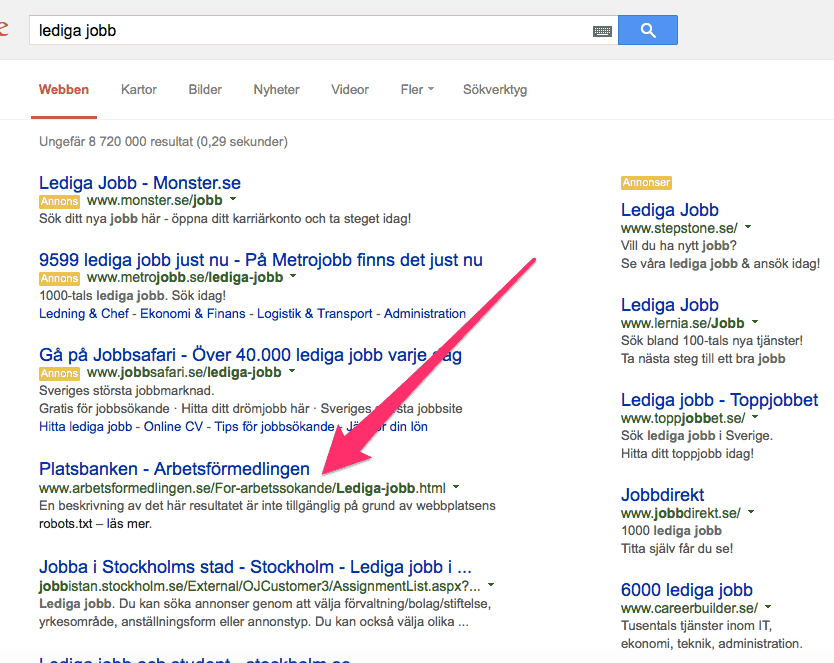

Bruk av «access denied»-kommandoen i robots.txt skal normalt stoppe Google fra å gjennomsøke innholdet du ønsker å holde utenfor indeksen. En advarsel bør imidlertid utstedes – hvis selve URL-en er koblet fra et sted som Google kan søke i, vil den fortsatt bli indeksert.  Over ser du et eksempel på en nettside som rangerer først på et konkurrerende ord til tross for at eierne prøver å stenge Google ute.

Over ser du et eksempel på en nettside som rangerer først på et konkurrerende ord til tross for at eierne prøver å stenge Google ute.

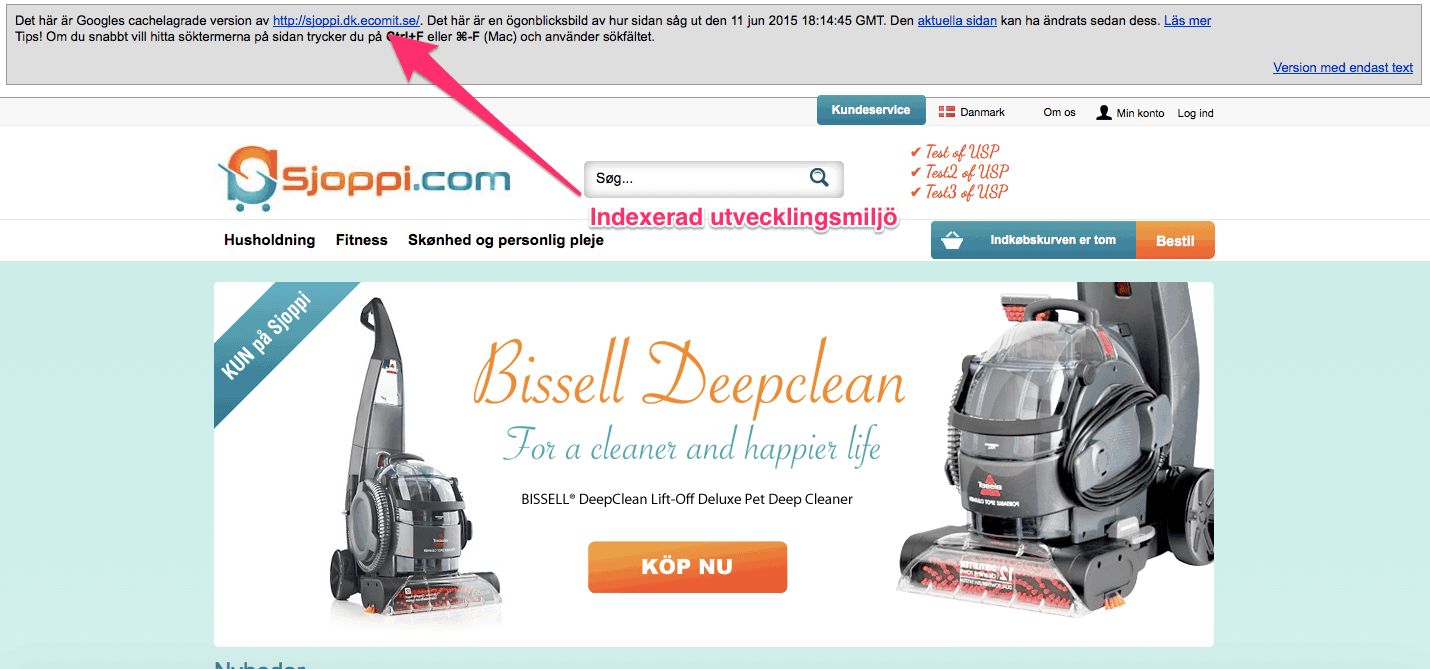

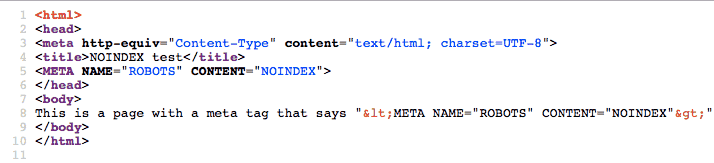

Indekseringsdirektiver med metakoder

Den beste måten for deg å hindre søkemotorer fra å behandle innholdet ditt uten å ty til passordbeskyttelse er ganske enkelt å bruke " noindex ", en metakode i et nettsteds kode. Dette vil føre til at siden aldri blir indeksert, enten den har lenker eller ikke. Det er spesielt viktig å sikre at Google ikke indekserer utviklingsmiljøer. Det er veldig vanlig at nettbyråer neglisjerer dette og ingen indeks er en god måte å ekskludere Google fra utviklingsmiljøet.  Konsekvensen av å ikke holde Google trygt fra utviklingsmiljøet ditt er at du kan få flere versjoner av nettsiden din i Googles indeks og det vil forvirre Google og en forvirret Google er dårlig for din rangering og dermed trafikken fra Google. Et ord til forsiktighet: Hvis du bruker robots.TXT-direktivet og Noindex samtidig, vil Google fortsatt indeksere URL-en. Det er rett og galt fordi disse to er i konflikt med hverandre, og sier i utgangspunktet til Google at «Ikke gjennmosøk denne siden eller mappen». Dette betyr at Google ikke forstår Noindex-metakoden på siden og indekserer siden uansett – hvis den er koblet til et sted Google kan gjennomsøke. Her er et eksempel: Dette er Matt Cutts Robot.TXT-fil.

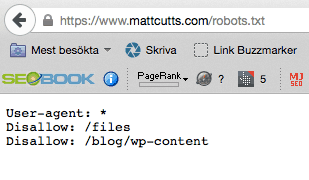

Konsekvensen av å ikke holde Google trygt fra utviklingsmiljøet ditt er at du kan få flere versjoner av nettsiden din i Googles indeks og det vil forvirre Google og en forvirret Google er dårlig for din rangering og dermed trafikken fra Google. Et ord til forsiktighet: Hvis du bruker robots.TXT-direktivet og Noindex samtidig, vil Google fortsatt indeksere URL-en. Det er rett og galt fordi disse to er i konflikt med hverandre, og sier i utgangspunktet til Google at «Ikke gjennmosøk denne siden eller mappen». Dette betyr at Google ikke forstår Noindex-metakoden på siden og indekserer siden uansett – hvis den er koblet til et sted Google kan gjennomsøke. Her er et eksempel: Dette er Matt Cutts Robot.TXT-fil.  Merk at han blokkerte mappen "filer" Her er en testside som Matt opprettet med "no-index"

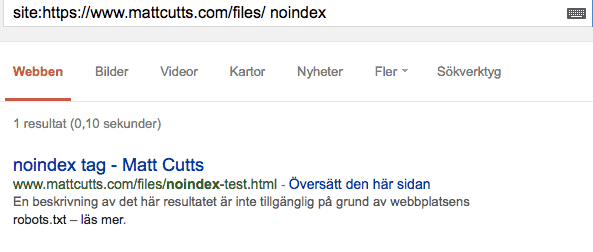

Merk at han blokkerte mappen "filer" Her er en testside som Matt opprettet med "no-index"  Nedenfor er den samme testsiden i Google. Regelen hans om Noindex i metataggen fungerer ikke fordi robots.TXT er aktiv, noe som igjen betyr at URL-en er indeksert:

Nedenfor er den samme testsiden i Google. Regelen hans om Noindex i metataggen fungerer ikke fordi robots.TXT er aktiv, noe som igjen betyr at URL-en er indeksert:

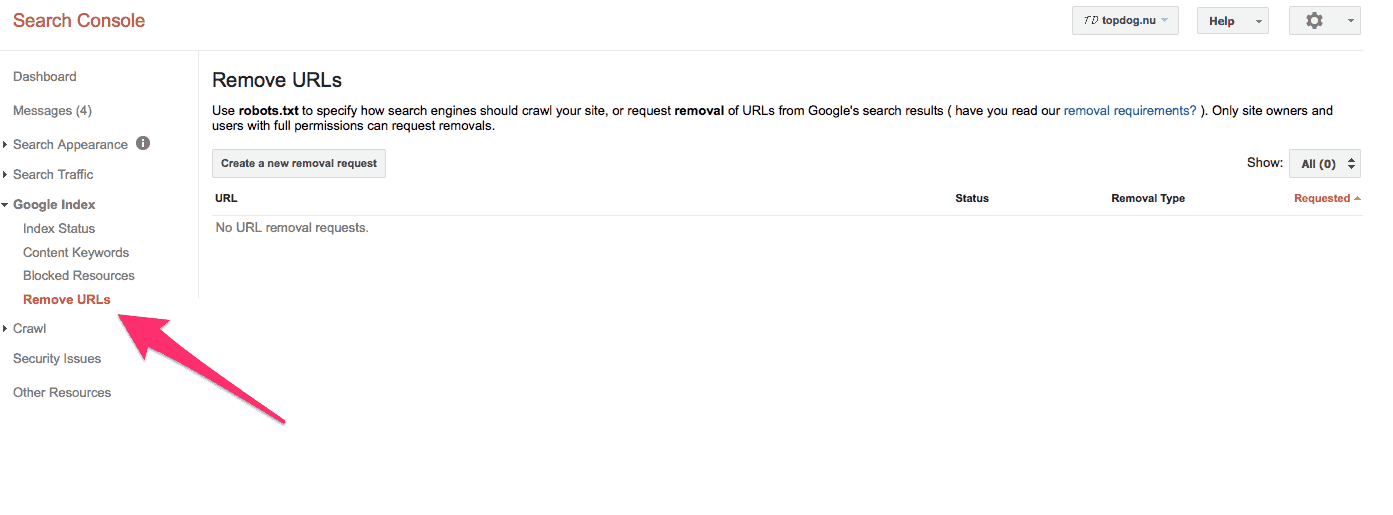

Slik fjerner du et nettsted fra Googles indeks (de-indeksering)

Den beste måten å fjerne et nettsted eller en mappe fra Googles indeks på er å bruke verktøy for nettredaktører.  1. Logg inn på Webmaster Tools 2. Velg sideprofilen du vil fjerne 3. Klikk på "Google Index" til venstre 4. Klikk på "Fjern URLs" 5 Klikk på "New Removal Request" 6. Skriv inn URL-en eller mappen du ønsker å fjerne 7. Klikk på "yes remove this page" 8. Klikk på "Send request" Denne handlingen, for å fjerne nettadresser via Google Webmaster Tool, men , du er kun gyldig i 90 dager – dette betyr at du har det bedre med metodene som jeg har beskrevet for deg ovenfor.

1. Logg inn på Webmaster Tools 2. Velg sideprofilen du vil fjerne 3. Klikk på "Google Index" til venstre 4. Klikk på "Fjern URLs" 5 Klikk på "New Removal Request" 6. Skriv inn URL-en eller mappen du ønsker å fjerne 7. Klikk på "yes remove this page" 8. Klikk på "Send request" Denne handlingen, for å fjerne nettadresser via Google Webmaster Tool, men , du er kun gyldig i 90 dager – dette betyr at du har det bedre med metodene som jeg har beskrevet for deg ovenfor.